ログイン

サイトを作成

ウェブサイトのリピート情報はSEOに不利?完全解説

この記事では、重複情報がSEOに良くない理由を別の視点から説明する。一部の重複は許容できるかもしれない。しかし、過度な重複は、ユーザーエクスペリエンス、クロール効率、コンテンツの品質シグナルに影響を与え、SEOを悪化させる可能性がある。

図書館の中では、本は主題、著者、出版年ごとにきちんと整理されている。 しかし問題がある。

その多くは全く同じ内容で、中には同じタイトルでも表紙が違うものさえある。 どの本を選べばいいのか? どの本が最も権威があり、価値があるのか? このような混乱感は、重複情報を扱う際に検索エンジンが遭遇する問題でもある。

重複コンテンツや繰り返される情報は、SEOにおいて大いに議論されるトピックである。 しかし、これには誤解もある。 この記事では、主にこの問題を取り上げ、重複コンテンツに対処する際に考慮する必要があるすべての問題についても説明します。

重複コンテンツの理解

重複コンテンツとは、簡単に言うと、同じWebサイト内、または複数のWebサイトにまたがって同じテキスト、画像、コードが存在することです。 また、一部は同じでも表現形式が微妙に異なる重複コンテンツも指します。

重複コンテンツの判断基準は通常、検索エンジンのアルゴリズムによって決定され、検索エンジンはウェブページのテキスト、構造、コードをいくつかの次元で分析し、コンテンツの重複を判断することがある。

- テキストの類似性とコンテンツのフォーマット

- コンテンツの独自価値

- ページ構造とコード

- URLの重複

- 類似したメタタグとタイトル

- 翻訳された言語バージョン

では、ウェブサイトの繰り返し情報はSEOに悪いのでしょうか?

ここに認知の誤解がある:ウェブサイトのSEOは、多少の情報の繰り返しで悪くなることはない。

実際には、その理由はさまざまな要因にある。 Googleがページをクロールし、インデックスし、ランキングする際に、様々な要素を考慮するからだ。

そこで、重複コンテンツがSEOにどのような影響を与えるのか、詳しく探っていこう。

重複コンテンツがSEOに与える影響とは?

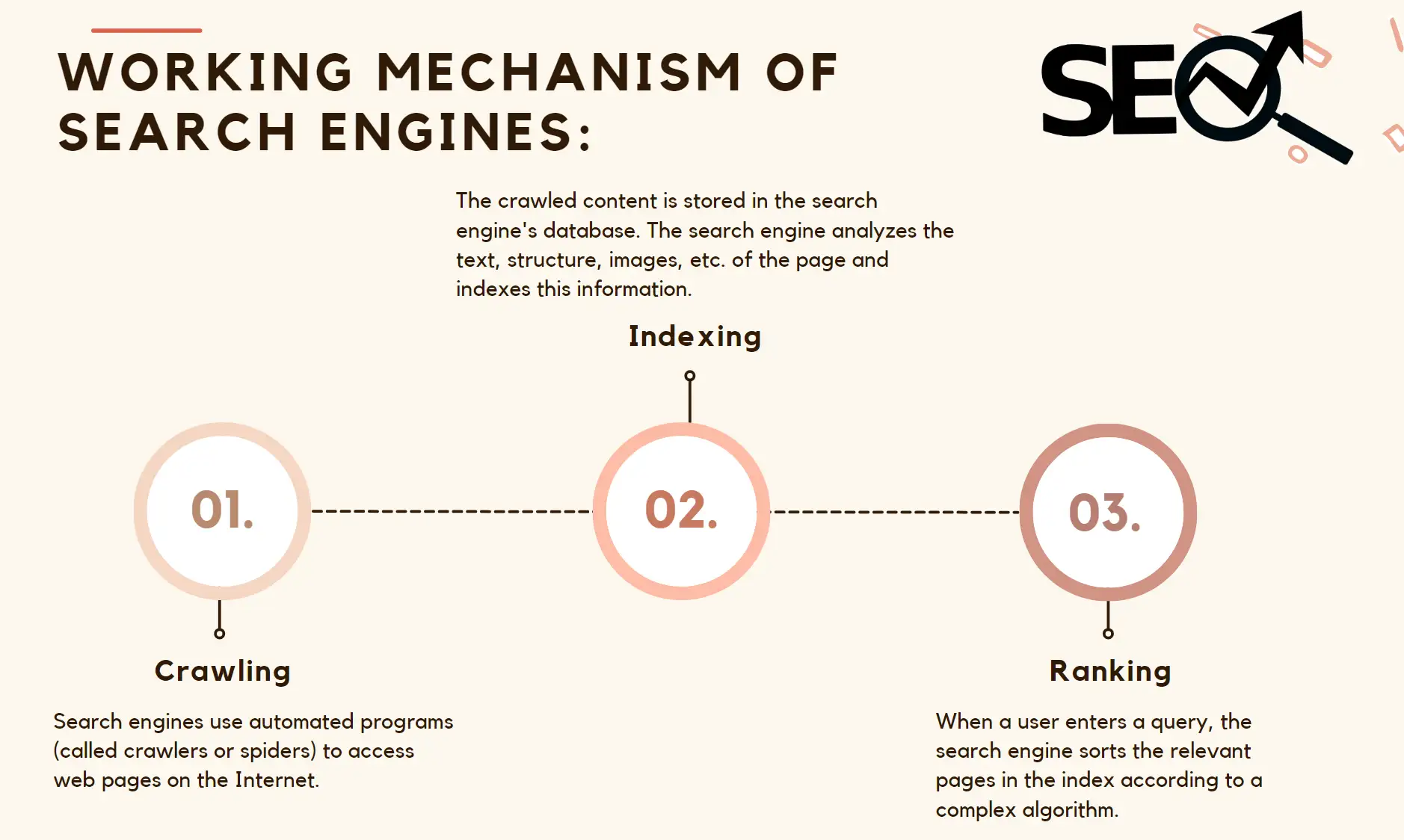

重複コンテンツがSEOに与える影響を認識するためには、まず、検索エンジンがどのようにコンテンツをクロールするのかを認識するために、検索エンジンの動作メカニズムという原点に立ち返る必要がある。

検索エンジンの仕組み

ページ・オーソリティの希薄化

ページ・オーソリティ(Page Authority)またはページランク(Page Rank)は、検索エンジンが特定のトピックやキーワードに対するウェブページのオーソリティや関連性を測定するために使用する指標です。 この概念は、検索結果でどのページを上位にランク付けするかを決定するために、Googleによって最初に導入されました。

複数のページに重複コンテンツが含まれていると、検索エンジンはどのページがより重視されるべきかを正確に判断することができず、結果的に検索エンジンのページでのパフォーマンスが低下してしまいます。

オーソリティの観点から見た重複コンテンツの主な理由をいくつか挙げてみましょう:

- 同じコンテンツを指す複数のURL

- 重複または類似コンテンツのページ

- 外部リンクの割り当て

- 内部リンク構造

同じコンテンツが異なるURLで存在する場合(カテゴリー、タグ、パラメータ化されたURLなどで生成された複数のページなど)、検索エンジンはこれらのURLを異なるページとして扱います。 コンテンツは同じであるにもかかわらず、ウェイトがこれらのページに分散され、その結果、個々のページがそれにふさわしいSEOウェイトを得ることに集中できなくなる。

全体として、分散型ウェイト付けの核となる問題は、検索エンジンのアルゴリズムが最適なページが誰なのかを判断できないことです。そのため、ページ内に重複したコンテンツや類似したコンテンツがあると、ウェイト分配の面で複数のページが互いに足を引っ張り合うことになり、その結果、すべてのページの全体的なSEOパフォーマンスが弱まってしまうのです。

インデックスの問題

ウェブページをクロールした後、検索エンジンはそのページのコンテンツを分析し、巨大なデータベースに保存することは、前回の記事ですでに詳しく説明した。 このプロセスをインデックス化と呼び、インデックス化されたページのみが検索結果に表示される。 インデックスされなかったページは、たとえ存在してもユーザーに表示されないことになる。

クロールを行う際には、「クロールバジェット」と呼ばれるものがあることを知っておく必要がある。これは、検索エンジンのクローラーには、1日にウェブサイトをクロールできるページ数に限りがあることを意味する。 重複コンテンツを含むウェブサイト上のページがクロールされると、クローラーはこれらの類似ページのクロールに時間とリソースを費やすことになり、価値の高いユニークなコンテンツに割り当てられるべきクロール予算を無駄にしてしまう。

ネガティブなUX

ユーザーにとって、複数のページをクリックしてもほとんど同じコンテンツが表示されるのは、同じシーンの映画を何度も見るようなものだ。

重複コンテンツは、ウェブサイトユーザーの満足度にマイナスの役割を果たしているに違いない。 いつも同じコンテンツを読むことを考えてみよう。ユーザーはそのような刺激のないウェブサイトから容赦なく退出し、その結果、直帰率が高くなり、ウェブサイトの滞在時間が短くなる。

重複コンテンツに関するグーグルの方針声明

Googleは、重複コンテンツがウェブサイトにペナルティを与えることはないとしている。 なぜなら、検索エンジンの主な関心事は、検索から最も関連性の高い有益な結果をユーザーに提供することだからだ。 したがって、重複コンテンツがランキングに直接影響することはありませんが、重複コンテンツがコンテンツの表示方法やインデックスに影響する可能性はあります。 ウェブサイトのSEOパフォーマンスを最適化するために、ウェブサイトの所有者は、コンテンツの独自性に焦点を当て、canonicalタグとリダイレクトを適切に使用し、検索エンジンのベストプラクティスを遵守して、ウェブサイトのコンテンツとユーザーエクスペリエンスの品質を確保する必要があります。

重複コンテンツを避けるには?

オリジナルコンテンツを作る

ユーザーは独創的で価値のあるものを好み、Googleもこの好みに従います。 私たちは、キーワード、つまりユーザーの検索語を中心にウェブサイトのコンテンツを書いています。 私たちは、視聴者の真のニーズが何であるかを入れる必要があります。 彼らのペインポイントは何か? これがオリジナルコンテンツを書く際の最優先事項だ。

そして、そのコンテンツが高品質でオリジナルなものであること、本当に読みやすく洞察力のあるコンテンツであることだけを確認すること。 これらが魅力的なコンテンツを書くための条件です。

Canonicalタグの使用

ウェブサイトのページには多くのコンテンツがあるため、特にブログのページではテーマの重複が避けられません。 似たようなページや重複したページがある場合、どのバージョンのページがメインバージョンであるかを検索エンジンに伝えるためにcanonicalタグが必要になります。すべてのバリアントでcanonicalタグを使い、メインバージョンを指すようにします。 これはページのパーミッションを統合するのに役立ちます。

301リダイレクトの使用

301ディレクションは、重複コンテンツを避けるための措置として、ウェブサイトによって一般的に使用されています。 301ディレクションはHTTPステータスコードで、検索エンジンとユーザーに対して、ユーザーが特定のページにアクセスすると、サーバーが自動的に新しいページにリダイレクトすることを伝えるために使用されます。

ページやURLが変更された場合、301リダイレクトを使用することで、ユーザーは404エラーページに遭遇することなく、自動的に正しいページにリダイレクトされます。

コンテンツのモニタリング

SEOは単に完璧を目指すものではなく、絶え間ない最適化のプロセスであることを忘れずに、定期的にウェブサイトの機能やパフォーマンスをテストすることは良い習慣です。

重複コンテンツだけでなく、サイトのパフォーマンスやユーザーエクスペリエンスに関するさまざまな問題をチェックすることができる。

重複コンテンツのチェック方法

したがって、重複コンテンツを見つけることは、ウェブサイトのオリジナリティとSEOのパフォーマンスを維持するために非常に重要であることがわかります。 重複コンテンツとは何かを特定する必要があり、これはウェブサイトのオーナーとSEOオプティマイザーの双方にとって非常に重要な作業である。

1. 手動チェック

最も簡単で直接的な方法は、記事の内容を直接Googleの検索バーにコピー&ペーストし、引用符で囲んで表示させることだ。 こうすることで、検索エンジンはページ内の同じテキストが他のページにも表示されているかどうかを表示する。 また、結果ページでは重複が赤くハイライトされます。これらは修正すべきコンテンツの問題です。

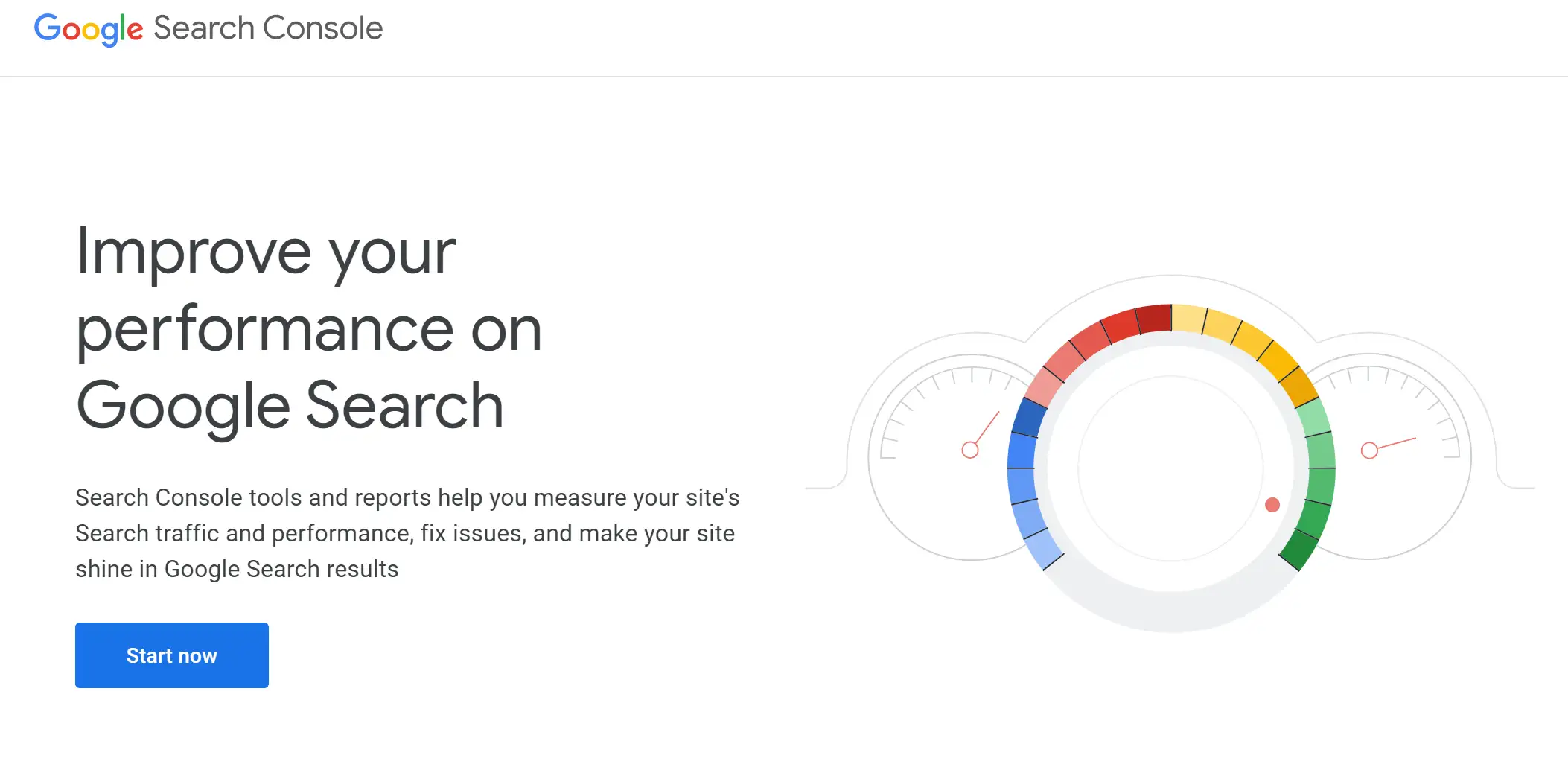

2. Googleサーチコンソール

GoogleはGoogle Search Consoleを開発し、重複コンテンツの問題に関するレポートを提供している。主に、問題のあるページを特定するために「ユーザー選択指定のない重複」エラーを探し、どのURLがすでにGoogleにインデックスされているかを把握する。

3. オンラインツールの使用

ウェブサイト内外の重複コンテンツを特定するのに役立つオンラインツールも数多く登場しています:

- Siteliner: このツールは、ウェブサイト上の重複コンテンツのあるページを完全にスキャンし、重複ワードの数とパーセンテージも表示します。

- Screaming Frog SEO Spider: このツールは、大小のウェブサイトをクロールし、ページのタイトル、メタディスクリプション、コンテンツに基づいて重複コンテンツの問題を見つけるために使用することができます。

4.剽窃検出ソフトウェア

剽窃検出ソフトのようなオンライン・ソフトウェアもあり、ウェブ上のあらゆるものの重複や類似コンテンツを見つけるのに役立ちます。

- Grammarly: Grammarlyは、記事中の文法的な問題を修正するだけでなく、ウェブ上の巨大なデータベースとあなたの記事を比較し、記事中の重複コンテンツを特定する剽窃チェック機能も提供しています。

- Scribber: Scribberは、元のテキストがどこで盗用されているかをチェックし、あなた自身のテキストとの類似性を比較することで、重複値の低いあなた自身のコンテンツとすることができます。

5. コンテンツ管理システム

コンテンツ管理システムは、組み込み機能、プラグイン、またはサードパーティ製ツールを統合し、さまざまな方法で重複コンテンツを検出・管理するツールです。

結論

図書館員が最も価値のある本を素早く推薦するためには、図書館はそれぞれの本のコンテンツがユニークでオリジナルであることを確認する必要がある。 同じ意味で、SEO対策も、検索エンジンがサイトのコンテンツを効率的にクロールして表示するために、情報の重複を避け、各ページが独自の価値を持つようにする必要があります。

ウェブサイトは、高品質でユーザーにとって価値のあるコンテンツを提供することによってのみ、長期にわたって強力で説得力のあるデジタルプレゼンスを築くことができるのです。 しかし、必ずしも重複コンテンツを恐れる必要はありません。 コンテンツはまずユーザーありきという精神を貫くことによってのみ、ウェブサイトのコンテンツはユーザーに真の価値を伝えることができ、それがSEOのベストプラクティスなのだ。 重複したウェブサイト・コンテンツに遭遇したとしても、適切なツールと戦略を用いることで、リスクを最小限に抑えることができるのです。

SEOについてもっと知りたいですか? Wegic Blogをお読みください。

その他の記事

著者

Kimmy

投稿日

Oct 31, 2024

記事を共有

続きを読む

SEOコピーライティングのコツ11選!

Nov 6, 2024

より良いSEOのためにウェブサイト構造を計画するには?

Nov 27, 2024

多言語SEO: グローバルにウェブサイトを強化

Nov 29, 2024

2025年WordPressのSEOプラグインおすすめ10選

Nov 18, 2024

SEO競合分析の方法: ステップバイステップガイド

Nov 18, 2024

動画最適化ガイド: サイトの読み込みを速くする

Nov 6, 2024

SEOとは何か、なぜ必要なのか?

Nov 1, 2024

2025年、ウェブサイトに最適なAI SEOツール10選

Dec 5, 2024

最新のブログ

Wegicで一分でウェブページを!

Wegicを使用して、先進的なAIであなたのニーズを見事で機能的なウェブサイトに変えましょう。

Wegicで無料トライアル、一クリックでサイトを構築!