Anmelden

Erstellen Sie Ihre Website

Datenbank-Skalierung: Strategien und bewährte Praktiken (aktualisiert 2025)

Um den Datenverkehr zu erhöhen und den Datenfluss zu verbessern, haben wir Strategien und bewährte Verfahren zusammengestellt, die Ihnen bei der Optimierung der Datenbankskalierung helfen. Jetzt ausprobieren.

Hat Ihr Unternehmen Schwierigkeiten, mit den wachsenden Anforderungen Schritt zu halten und die zunehmende Zahl von Daten und Benutzern effektiv zu verwalten? Dann ist es vielleicht an der Zeit, Ihre Datenbank zu skalieren. In diesem Artikel erfahren Sie, wie Sie Ihr überlastetes System optimieren und auf künftiges Wachstum vorbereiten können.

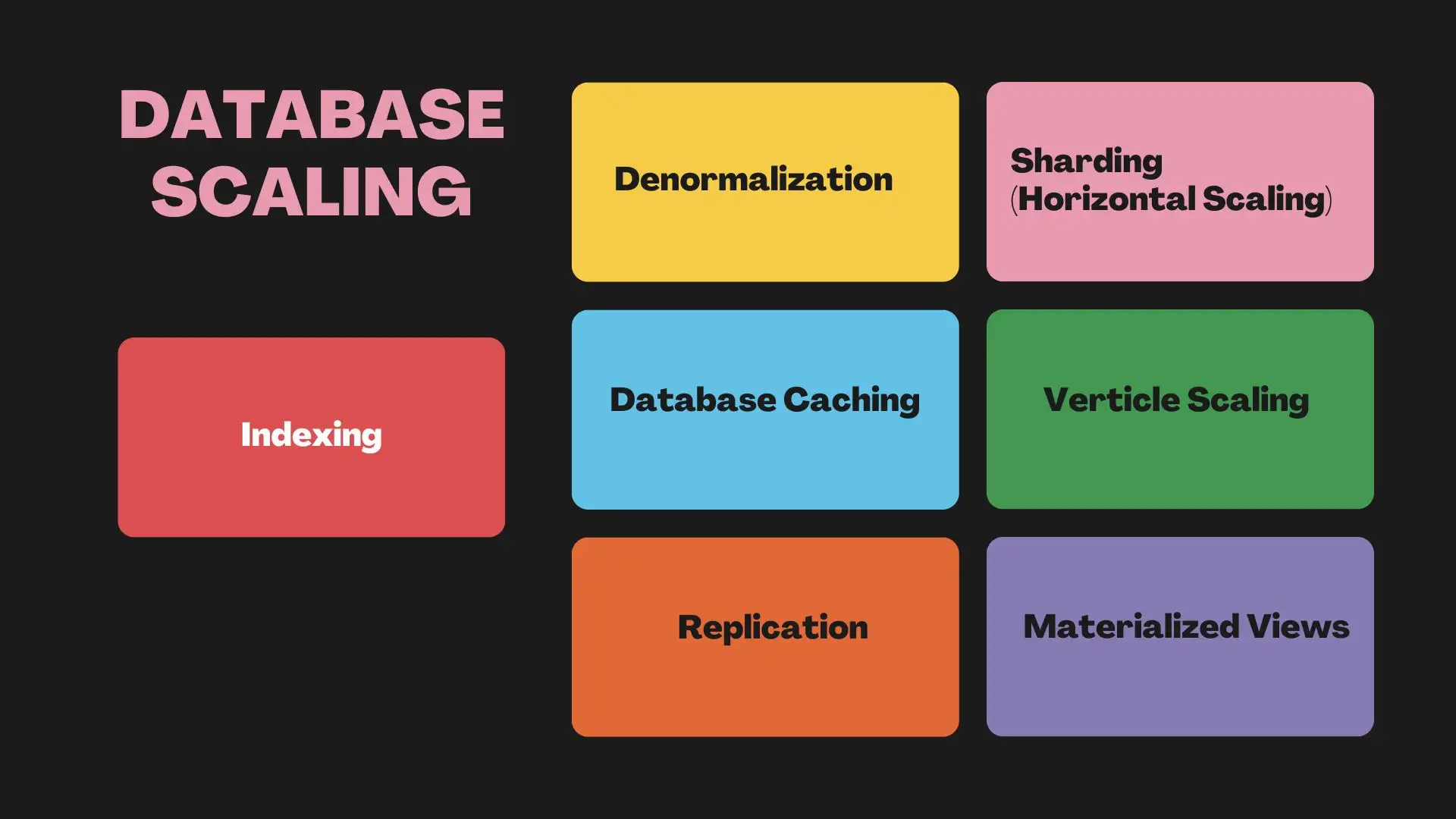

Was ist Datenbank-Skalierung?

Eine Datenbank ist eine organisierte Sammlung von Daten, die oft als strukturierte Daten bezeichnet werden und auf die auf einem Computersystem gespeichert und zugegriffen werden kann. Datenbanken sind speziell darauf ausgelegt, Informationen effizient zu verwalten, zu speichern und abzurufen. Ein Datenbankmanagementsystem (DBMS) steuert normalerweise eine Datenbank. Es vereinfacht den Zugriff, die Verwaltung und die Aktualisierung der Daten in der Datenbank.

Datenbankskalierung bedeutet bedeutet, die Größe und Kapazität einer Datenbank anzupassen. Dies dient dazu, den wachsenden Anforderungen, wie mehr Daten und Benutzer, gerecht zu werden. Sie muss Leistung, Reaktionsfähigkeit und Zuverlässigkeit gewährleisten. Der Aufbau einer skalierbaren Datenbank gewährleistet ein nahtloses Benutzererlebnis, auch wenn das System erweitert wird.

Datenbank-Skalierung: Strategien und bewährte Praktiken (aktualisiert 2025)

Sind Sie bereit, Ihre Datenbank im Hinblick auf Wachstum und Leistung zu optimieren? Ich habe die wichtigsten Strategien und Best Practices zusammengestellt, die Ihnen helfen, Ihre Datenbank effektiv zu skalieren.

1 # Indexierung

Die Datenbankindizierung ist für die Skalierung von Datenbanken unerlässlich. Sie beschleunigt die Datenabfrage, indem sie schnellere Suchvorgänge ermöglicht. Sie ist wie ein Buchindex, der hilft, Themen zu finden, ohne jede Seite durchsuchen zu müssen. Indizes verbessern zwar die Sucheffizienz, erfordern aber zusätzliche Speicher- und Schreibvorgänge, um sie zu pflegen.

Zu den wichtigsten Praktiken gehören die regelmäßige Analyse und Optimierung von Abfragen, die Verwendung von Verbindungspools für eine effiziente Verwaltung, die Partitionierung großer Tabellen und die Auswahl des richtigen Datenbanktyps (SQL vs. NoSQL). Berücksichtigen Sie bei der Entwicklung von Indizes die Indexgröße, die Suchgeschwindigkeit, die Wartung und die Fehlertoleranz. Zusammen tragen diese Faktoren zur Verbesserung der Gesamteffizienz und -leistung der Datenbank bei.

2 # Denormalisierung

Die Denormalisierung ist eine der Datenbankskalierungstechniken zur Optimierung zur Optimierung. Sie verbessert die Leseleistung, indem sie redundante Daten zu einem zuvor normalisierten Schema hinzufügt. Sie trägt dazu bei, die Zugriffskosten zu senken, die durch mehrere Tabellen-Joins in einer normalisierten Datenbank steigen können, insbesondere bei großen Tabellen und Indizes.

Die Denormalisierung beschleunigt Abfragen durch Hinzufügen von vorberechneter Redundanz. Sie erhöht jedoch den Speicherplatz und kann zu Dateninkonsistenzen führen. Zu den gängigen Techniken gehören die Aufteilung von Tabellen und das Hinzufügen abgeleiteter oder redundanter Spalten. Die Verwendung von gespiegelten Tabellen ist ebenfalls üblich. Verwechseln Sie diesen Prozess nicht mit einer Datenbank, die nie normalisiert wurde. Die Denormalisierung erfolgt in der Regel, nachdem ein Schema durch Normalisierung optimiert wurde.

Vorteile der Denormalisierung

Bessere Skalierbarkeit: Die Denormalisierung kann Datenbanksysteme skalierbarer machen. Dazu wird die Anzahl der Tabellen reduziert und die Leistung verbessert. Die Denormalisierung reduziert die Anzahl der Datenbanktransaktionen beim Lesen von Daten. Durch diese reduzierte Anzahl von Transaktionen kann man sich an unterschiedliche Benutzerlasten anpassen und so die Skalierbarkeit der Anwendung verbessern.

Reduzierte Komplexität: Die Denormalisierung kann das Datenbankschema vereinfachen. Dies geschieht durch die Reduzierung von Join-Abfragen und die Kombination verwandter Daten in weniger Tabellen. Ein einfacheres Schema ist leichter zu verstehen, abzufragen und zu verwalten. Darüber hinaus trägt diese Einfachheit dazu bei, Fehler im Zusammenhang mit Datenbankoperationen erheblich zu reduzieren.

Verbesserte Abfrageleistung: Denormalisierung erhöht die Abfragegeschwindigkeit durch Reduzierung von Joins. Je nach Anforderung kann die Abfrage eines normalisierten Datenspeichers mehrere Joins verschiedener Tabellen erfordern.

Nachteile der Denormalisierung:

Reduzierte Datenintegrität: Denormalisierung führt zu redundanten Daten. Dies erhöht das Risiko von Inkonsistenzen. Aktualisierungen verbreiten sich möglicherweise nicht korrekt über alle redundanten Felder.

Höhere Komplexität: Die Denormalisierung kann einige Abfragen vereinfachen. Sie kann aber auch die Datenbank verkomplizieren, indem sie doppelte Daten erzeugt. Dies kann zu Diskrepanzen zwischen den Datensätzen führen, insbesondere in Szenarien mit gespiegelten Datenbanken.

Höhere Speicheranforderungen und -kosten: Denormalisierung schafft redundante Daten. Techniken wie Datenduplikation und Tabellenspiegelung beanspruchen Platz. Dies treibt die Speicherkosten in die Höhe, die bei großen Datensätzen hoch sein können.

Mehr Updates und geringere Flexibilität : Bei redundanten Daten steigt die Häufigkeit der Updates, was die Wartung der Datenbank erschwert. Dies wiederum schränkt die Flexibilität des Systems ein und erschwert die Anpassung an sich ändernde Anforderungen oder Änderungen.

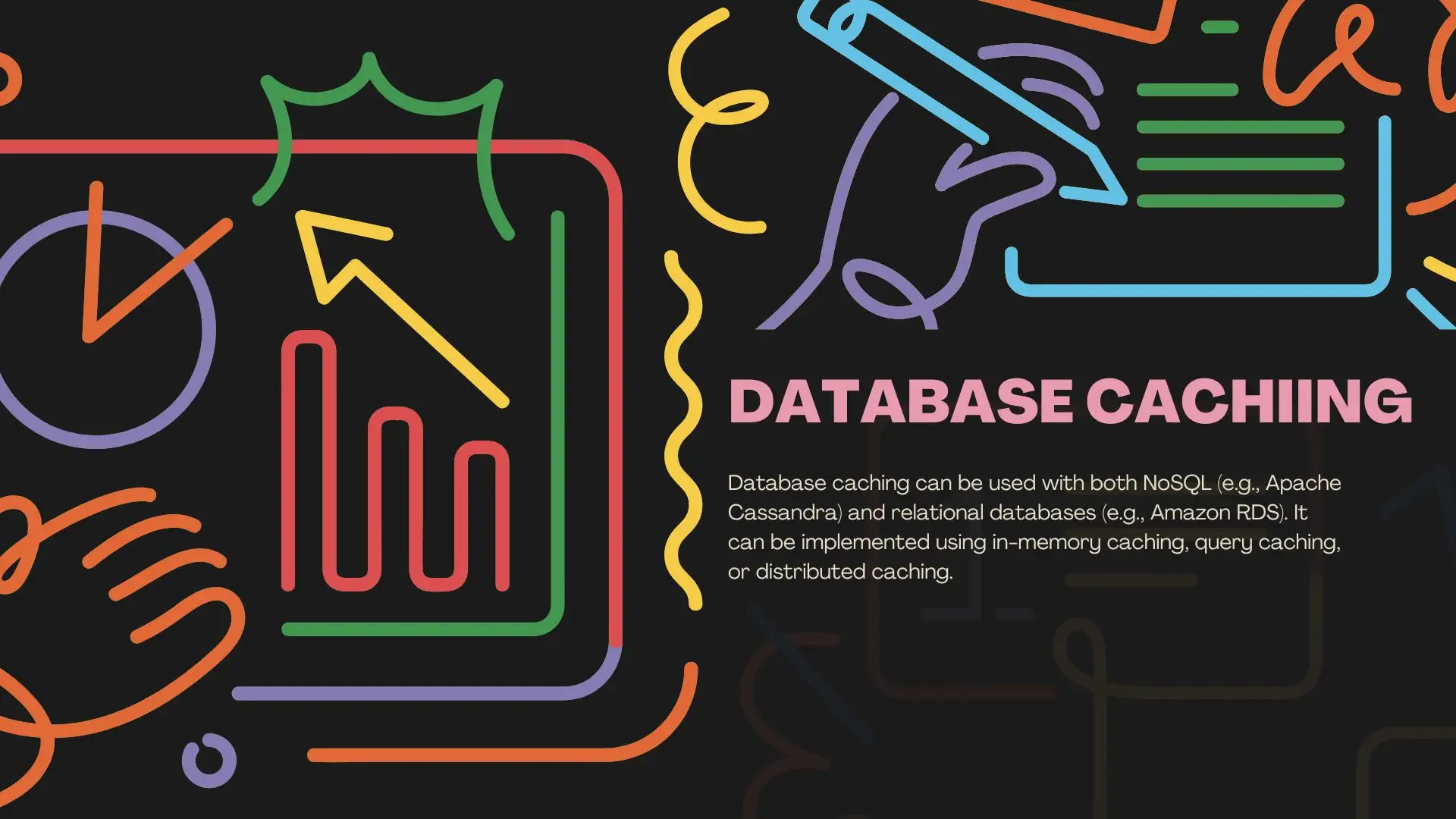

3 # Datenbank-Caching

Die Zwischenspeicherung von Datenbanken ist ebenfalls eine der Techniken zur Skalierung von Datenbanken. Sie speichert häufig aufgerufene Daten im Speicher. Dadurch wird der Bedarf an wiederholten Datenbankabfragen und Berechnungen reduziert. Diese Methode steigert die Skalierbarkeit und Leistung von Anwendungen. Sie verkürzt den Zeitaufwand für das Abrufen von Daten aus persistenten Speichern wie Festplatten oder SSDs.

Vorteile des Datenbank-Cachings

Geringere Datenbanklast: Durch das Zwischenspeichern werden häufige Abfragen aus der Datenbank entlastet. Dies verringert die Belastung der Serverressourcen. Es ermöglicht der Datenbank, mehr Anfragen effizient zu bearbeiten.

Leistungsverbesserung: Das Caching speichert häufig auf Daten im Speicher. Es verkürzt die Antwortzeiten drastisch und beschleunigt den Datenabruf.

Geringere Latenz: Zwischengespeicherte Daten befinden sich in schnellen, speicherinternen Strukturen. Dies minimiert die Latenz und beschleunigt die Reaktionszeiten für Benutzer und Anwendungen.

Weniger Festplatten-I / O-Operationen: Das Caching reduziert das Lesen von Festplatten. Es beschleunigt den Datenzugriff und ist effizienter als die plattenbasierte Speicherung.

Nachteile des Datenbank-Cachings

Cache-Invalidierung: Es ist schwer zu sagen, wann zwischengespeicherte Daten aktualisiert werden müssen. Aber es ist entscheidend für die Datenkonsistenz.

Höhere Kosten für externen Cache: Externes Caching erfordert oft DRAM. Es ist teurer als die Verwendung von SSDs oder HDDs für die Speicherung.

Verminderte Verfügbarkeit: Externe Caches haben in der Regel eine geringere Hochverfügbarkeit (HA) als Datenbanken. Dies kann zu Ausfällen führen und die Datenbank bei Cache-Ausfällen belasten.

Störung des Datenbank-Cache: Ein externer Cache kann den internen Cache einer Datenbank stören. Dies macht ihn weniger effektiv und erhöht den Festplattenzugriff.

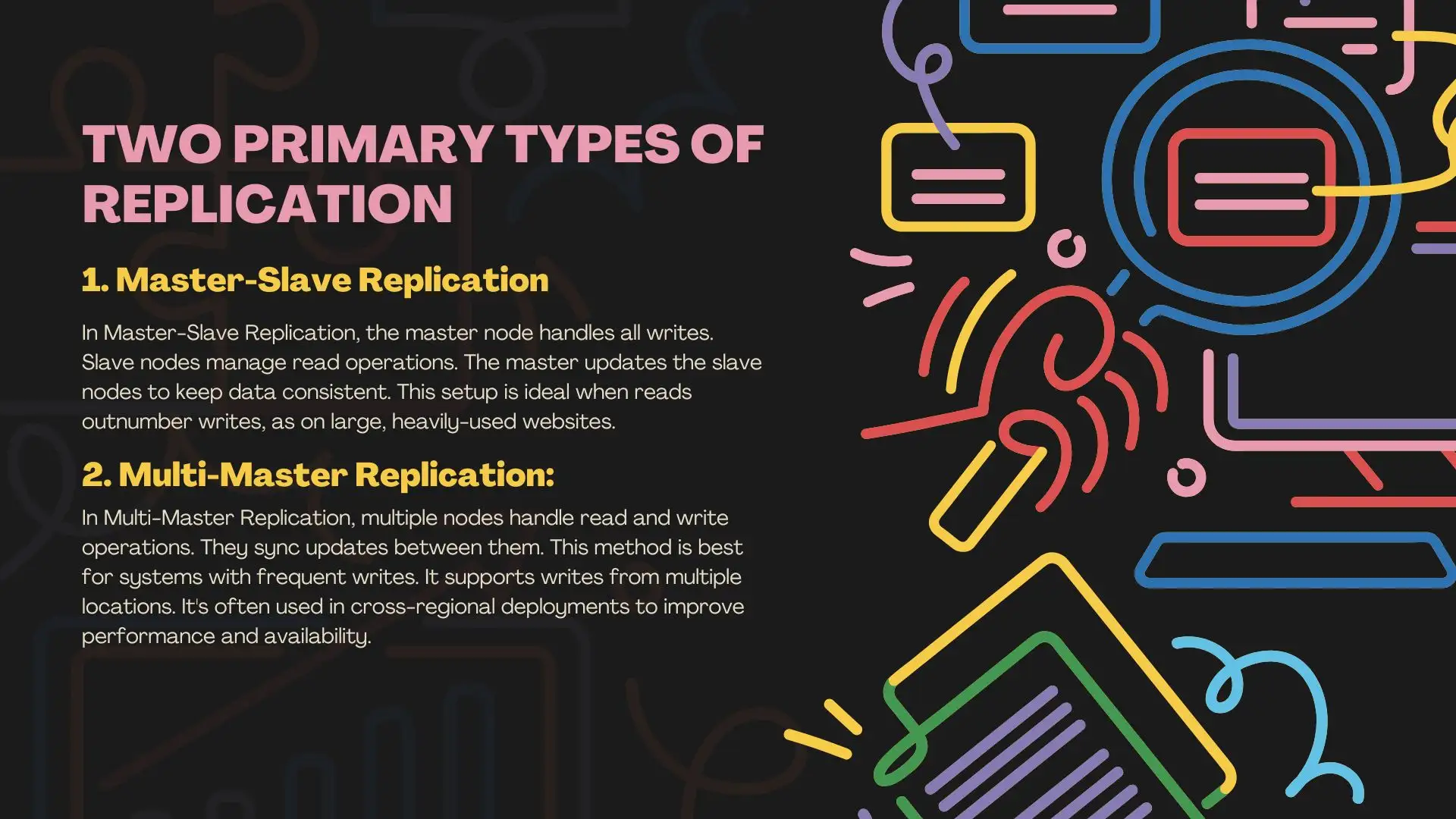

4 # Replikation

Jetzt werde ich eine weitere Technik für die Datenbankskalierung vorstellen: die Replikation. Die Datenbankreplikation kopiert die Datenbank und speichert sie an verschiedenen lokalen oder Cloud-Standorten . Dadurch werden Datenzugänglichkeit, Fehlertoleranz und Zuverlässigkeit gewährleistet. Sie ermöglicht den Benutzern den Zugriff auf dieselben aktuellen Daten, was die Systemleistung und die Wiederherstellung im Katastrophenfall verbessert. Die Replikation erfolgt in der Regel in Echtzeit, wenn die Daten erstellt, aktualisiert oder gelöscht werden, kann aber auch als einmaliger oder geplanter Stapelprozess erfolgen.

Vorteile der Replikation

Verbesserte Wiederherstellung im Katastrophenfall: Durch die Datenreplikation werden Datenbankkopien an mehreren Standorten erstellt. Dies gewährleistet hohe Verfügbarkeit und Zugriff bei Ausfällen nach Katastrophen.

Reduzierte Serverlast: Bei der Replikation werden Daten in eine replizierte Umgebung verlagert. Dadurch wird die primäre Datenbank entlastet. Dadurch wird die Leistung optimiert und es werden Ressourcen freigesetzt.

Verbesserte Datenanalyse: Die Replikation schafft isolierte Umgebungen für die Ausführung komplexer Abfragen. Auf diese Weise können Analysten Daten untersuchen, ohne Kernsysteme zu beeinträchtigen.

Real-Time Business Intelligence: Die Replikation ermöglicht den Echtzeit-Datenzugriff über alle Geschäftsbereiche hinweg. Dies verbessert die Genauigkeit der Berichterstattung und die Entscheidungsfindung. Außerdem werden Daten aus verschiedenen Quellen integriert, um die Geschäftsentwicklung zu verbessern.

Unterstützung für KI / ML-Anwendungen: Replizierte Datenbanken bieten konsistente, aktuelle Datensätze für das Training von KI / ML-Modellen. Dies verbessert die Vorhersagegenauigkeit und ermöglicht datengesteuerte Anwendungen in Echtzeit.

Nachteile der Datenreplikation

Bedrohung durch Datenkompromisse: Fehler Fehler in der Replikation können Daten beschädigen oder verlieren. Dies stellt ein erhebliches Risiko für die Datenintegrität dar.

Erhöhte Kosten: Die Datenreplikation erfordert die Speicherung und Übertragung mehrerer Datenkopien. Sie erfordert viel Speicherplatz und Bandbreite. Dies führt zu höheren Speicher- und Betriebskosten, einschließlich des Bedarfs an zusätzlichem Personal zur Überwachung und Verwaltung des Prozesses.

Risiken für die Datensicherheit : Die Replikation von Daten, insbesondere auf entfernte Server, birgt potenzielle Sicherheitslücken. Außerdem wird die Einhaltung von Datenschutzgesetzen erschwert. Unbefugter Zugriff und Cyber-Bedrohungen sind jetzt ein größeres Problem.

5 # Sharing (Horizontale Skalierung)

Das Sharding von Datenbanken ist auch eine Möglichkeit, eine Datenbank zu skalieren. Es teilt Daten in Segmente, sogenannte Shards , auf und speichert sie auf separaten Servern. Dadurch wird die Arbeitslast verteilt , was sowohl die Leistung als auch die Skalierbarkeit verbessert. Außerdem erhöht das Sharding die Fehlertoleranz. Es lässt das System auch dann laufen, wenn ein Shard oder Server ausfällt. Das macht es zu einer belastbaren Lösung.

Sharding wird häufig in Cloud-Anwendungen wie SaaS verwendet verwendet . Es ermöglicht mehreren Mietern den Zugriff auf große Datensätze. Es kann auch zeitlich für Szenarien wie die Datenaufnahme von verteilten Geräten organisiert werden. Sharding funktioniert am besten, wenn Transaktionen einen einzigen Sharding-Schlüssel verwenden. Dies optimiert die Abfrageleistung und minimiert die shard-übergreifende Kommunikation.

Vorteile des Shardings

Verbesserte Leistung: Sharding verteilt Daten auf mehrere Server. Es reduziert die Belastung jedes Servers und beschleunigt die Beantwortung von Anfragen.

Erhöhte Kapazität : Die gemeinsame Nutzung ermöglicht eine einfache Skalierbarkeit. Wenn die Daten wachsen, können wir Server hinzufügen, um die Kapazität der Datenbank zu erhöhen, ohne die Leistung zu beeinträchtigen.

Fehlerisolierung: Wenn ein Splitter ausfällt, gehen nur einige Daten verloren. Der Rest des Systems bleibt betriebsbereit. Dies verbessert die Ausfallsicherheit.

Nachteile des Shardings

Die gemeinsame Nutzung ist kompliziert : Sie erfordert eine sorgfältige Planung. Sie müssen entscheiden, wie die Daten verteilt werden, wie viele Shards erstellt werden sollen und wie die Abfragen an den richtigen Shard weitergeleitet werden sollen.

Herausforderungen bei der Datenverteilung : Es kann schwierig sein, sicherzustellen, dass die Daten gleichmäßig über die Shards verteilt sind. Wenn die Daten ungleichmäßig verteilt sind, können einige Shards überlastet werden, was die Leistungsvorteile des Shardings zunichte macht.

Komplexes Daten-Joining : Das Joining von Daten über mehrere Shards hinweg kann langsam und knifflig sein. Es kann die Abfrageleistung beeinträchtigen.

6 # Vertikale Skalierung

Vertikale Skalierung oder "Skalierung" bedeutet, dass einem einzelnen Server Ressourcen hinzugefügt werden, wenn er die Nachfrage nicht befriedigen kann. Dies bedeutet, dass CPU, Speicher oder Speicher hinzugefügt werden. Bei diesem Prozess wird die vorhandene Serverhardware aufgerüstet, um ihre Kapazität zu erhöhen.

Die vertikale Skalierung ist eine schnelle, einfache Lösung. Dies gilt für cloudbasierte Datenbanken. Oft können Sie die Ressourcen durch Anpassung der Servereinstellungen erhöhen. Das ist ideal, wenn wir die Leistung verbessern können, indem wir einfach die Ressourcen des Servers erweitern. Wir sollten die Arbeitslast nicht auf mehrere Server verteilen müssen.

Vorteile der vertikalen Skalierung

Vernünftige Aufteilung: Durch vertikales Sharing wird eine Tabelle in kleinere, zusammenhängende Teilmengen unterteilt. Sie können unabhängig voneinander verwaltet werden. Dies ermöglicht eine bessere Ressourcennutzung und Leistung in Teilen der Datenbank.

Einfach zu implementieren: vertikale Skalierung ist einfacher als die horizontale Skalierung. Sie erfordert keine Änderungen an der Architektur der App oder die Verwaltung verteilter Systeme.

Weniger Netzwerklatenz: Alle Ressourcen befinden sich auf einem einzigen Server. Dies minimiert die Netzwerklatenz und verbessert die Reaktionszeiten.

Effiziente Ressourcennutzung: Durch die Aktualisierung eines einzelnen Servers werden dessen Ressourcen maximiert. Bei einigen Workloads ist die vertikale Skalierung dadurch effizienter als bei der Verwendung mehrerer Server.

Nachteile der vertikalen Skalierung

Unausgewogene Belastung: Einige Scherben können mehr Verkehr erhalten als andere. Dies kann die Systemeffizienz verringern.

Komplexität des Managements: Die Verwaltung mehrerer Shards macht die Aufgaben komplexer. Dazu gehören Wartung, Backups und Synchronisierung. Jeder Shard arbeitet unabhängig und erfordert mehr Überwachung.

Begrenzte Kapazität : Die vertikale Skalierung hat physische Grenzen. Sobald ein Server seine maximale Kapazität erreicht hat, müssen andere Skalierungsmethoden erprobt werden.

Komplexe Abfragen : Das Abfragen oder Verbinden von Daten über mehrere Shards hinweg kann ineffizient und komplex sein und erfordert eine Koordinierung zwischen den Shards.

Einzelner Ausfallpunkt: : Da alle Vorgänge von einem einzigen Server abhängen, kann jeder Ausfall dieses Servers dazu führen, dass die gesamte Anwendung ausfällt.

7 # Materialisierte Ansichten

In der Datenverarbeitung ist eine materialisierte Ansicht ein Datenbankobjekt. Sie speichert die Ergebnisse einer Abfrage auf der Festplatte. Dadurch werden die Ergebnisse nicht jedes Mal neu berechnet, wenn die Abfrage ausgeführt wird. Dieser Prozess der Erstellung einer materialisierten Ansicht wird als Materialisierung bezeichnet bezeichnet . Materialisierte Ansichten verbessern die Leistung. Sie ermöglichen den schnellen Abruf von vorberechneten Daten.

Vorteile von materialisierten Ansichten

Verbesserte Abfrageleistung: Materialisierte Ansichten speichern vorberechnete Abfrageergebnisse. Dies verkürzt die Zeit, die zum Abrufen komplexer Daten benötigt wird. Dies ist besonders vorteilhaft bei Abfragen mit großen Datensätzen oder komplexen Berechnungen, wie z. B. Aggregationen.

Reduzierter Ressourcenverbrauch: Materialisierte Ansichten zwischenspeichern die Ergebnisse ressourcenintensiver Abfragen. Dies reduziert die Notwendigkeit einer wiederholten Abfrageausführung und senkt die CPU-, Speicher- und E / A-Auslastung.

Schnellerer Zugriff auf aggregierte Daten: Materialisierte Ansichten sind perfekt für die Speicherung der Ergebnisse von häufig durchgeführten Aggregationsabfragen. Sie ermöglichen einen schnelleren Zugriff auf zusammengefasste Informationen.

Entlastung der Arbeitslast: Sie können umfangreiche Berechnungen von Live-Datenabfragen entlasten. Dies verbessert die Leistung der Datenbank, indem die Arbeitslast über die Zeit verteilt wird.

Visuelle Daten: Materialisierte Ansichten bieten eine Momentaufnahme der Daten. Sie befinden sich bei ihrer Erstellung oder letzten Aktualisierung. Dies ist nützlich für historische Analysen oder Berichte.

Nachteile materialisierter Ansichten

Eingeschränkte Funktionalität: Nachdem Sie eine materialisierte Ansicht erstellt haben, können Sie ihre SQL-Definition nicht ändern. Sie können sie auch nicht durch eine andere Ansicht mit demselben Namen ersetzen. Materialisierte Ansichten können auch keine externen, Platzhaltertabellen oder logischen Ansichten abfragen. Sie unterstützen nur einen begrenzten Satz von SQL-Funktionen. Dies macht sie weniger flexibel für komplexe Abfragen. Außerdem können sie nicht in andere materialisierte Ansichten verschachtelt werden, was ihre Verwendung in der erweiterten Datenmodellierung einschränkt.

Begrenzte direkte Datenmanipulation: Sie können die Daten einer materialisierten Ansicht nicht mit COPY-, EXPORT-, LOAD- oder DML-Operationen aktualisieren. Dies verringert die Flexibilität bei der Verwaltung der Daten der Ansicht.

Wartungsaufwand: Um eine materialisierte Ansicht mit den Basisdaten zu synchronisieren, sind regelmäßige Aktualisierungen erforderlich. Dieser Aktualisierungsprozess kann einen hohen System-Overhead verursachen und Ressourcen verbrauchen. Er hängt von der Größe des Datensatzes und der Aktualisierungshäufigkeit ab.

Häufige Aktualisierungen erhöhen die Komplexität: Es ist schwieriger, materialisierte Ansichten zu pflegen, wenn sich die Quelldaten häufig ändern. Aktualisierungen müssen sorgfältig mit den Basistabellen koordiniert werden, um Inkonsistenzen zu vermeiden. Dies macht den Verwaltungsprozess noch komplexer.

Warum Sie eine skalierbare Datenbank haben sollten

Skalierbarkeit ist die Fähigkeit eines Systems, sich an veränderte Anforderungen anzupassen. Es muss wachsende Daten und Benutzer effizient verwalten. Hier sind einige der wichtigsten Gründe, warum eine skalierbare Datenbank für Ihr Unternehmen unerlässlich ist:

Verbesserte Zusammenarbeit: Eine skalierbare Datenbank ist ein zentrales, sicheres Repository. Sie ermöglicht allen Teammitgliedern den Zugriff auf Projektdaten. Sie verbessert die Entscheidungsfindung und rationalisiert die Arbeitsabläufe. Dies geschieht durch eine bessere gemeinsame Nutzung von Daten und Zusammenarbeit.

Unterstützt mehrere Datenquellen: Große Unternehmen müssen Daten aus mehreren Kanälen integrieren. Eine skalierbare Datenbank konsolidiert diese Quellen zu einem einheitlichen, zentralisierten Hub, was die Verwaltung verschiedener Informationsströme erleichtert.

Effizienter Umgang mit Wachstum : Mit der Expansion Ihres Unternehmens wachsen auch Ihre Daten und Benutzeranfragen. Eine skalierbare Datenbank kann sich leicht an dieses Wachstum anpassen. Sie vermeidet häufige Systemüberholungen und hält das Unternehmen am Laufen.

Verwaltet plötzliche Verkehrsschübe: Ereignisse mit hohem Verkehrsaufkommen, wie Feiertage oder Werbeaktionen, können die Benutzeraktivität in Unternehmenssystemen in die Höhe treiben. Eine skalierbare Datenbank kann die Kapazität schnell erhöhen. Sie hält das System bei Verkehrsspitzen stabil.

Verbessert die Leistung : Skalierbare Datenbanken optimieren die Ressourcennutzung und verhindern Leistungseinbußen bei hoher Belastung. Sie ermöglichen eine schnelle Datenabfrage, -speicherung und -verarbeitung. Dies erhöht die Reaktionszeiten und hält das System zuverlässig.

Verbessert die Benutzererfahrung: Eine skalierbare Datenbank hält Ihr System stabil. Sie verhindert Verzögerungen oder Ausfallzeiten, unabhängig davon, wie viele Benutzer Ihr Unternehmen hat. Dies führt zu einem reibungsloseren, zufriedenstellenden Benutzererlebnis.

Schlussfolgerung

Die Skalierung von Datenbanken ist entscheidend für eine effiziente Datenspeicherung und die Verbesserung der Leistung von Softwaresystemen. Von der Indizierung und Denormalisierung bis hin zu Daten-Caching, Replikation, Sharding, vertikaler Skalierung und materialisierten Ansichten gibt es eine Vielzahl von Strategien, aus denen Sie je nach den Anforderungen Ihres Systems wählen können.

Jeder Ansatz zur Skalierung von Datenbanken bringt seine eigenen einzigartigen Vorteile und Herausforderungen mit sich. Im Jahr 2025 ist es von entscheidender Bedeutung, die Strategie auszuwählen, die am besten zu Ihren Unternehmenszielen und Ihrer Infrastruktur passt.

Geschrieben von

Kimmy

Veröffentlicht am

Oct 29, 2024

Artikel teilen

Mehr lesen

Unser neuester Blog

Webseiten in einer Minute, mit Wegic!

Mit Wegic verwandeln Sie Ihre Anforderungen in beeindruckende, funktionale Websites mit fortschrittlicher KI

Kostenlose Testversion mit Wegic, erstellen Sie Ihre Seite mit einem Klick!